邵逸琦 半导体行业观察

2023年9月,一则短短的消息,就引发了三个硅谷巨头的股价波动。

这则消息的内容很简单,就是GOOGLE计划逐步放弃博通定制的TPU,最早在 2027 年转向Marvell,由它来定制新的AI芯片。

要知道,博通和Marvell在定制芯片领域可是老对手了,而GOOGLE又是对定制芯片需求最大的厂商之一,如果它选择其中一位作为长期合作伙伴,那么此消彼长之下,行业老大和第二就可能会出现互换位置的情况。

更重要的是,伴随着巨头模仿GOOGLE做自研芯片,定制芯片市场迅速膨胀,连英伟达都动了心,根据研究企业 650 Group 的估计,数据中心定制芯片市场今年将增长至 100 亿美金,到 2025 年将翻一番。Needham 分析师 Charles Shi 表示,到 2023 年,更广泛的定制芯片市场价值约为 300 亿美金,约占全球芯片年销售额的 5%。

博通之前举办了半导体解决方案的投资者日活动,对自己的半导体业务做了一个详尽的先容,尤其是对博通的定制XPU,半导体解决方案集团总裁 Charlie Kawwas强调,博通所定制的XPU在HBM上比英伟达B200多出了整整50%,博通可以比其他任何人做得更好、更快、更省电。

而在半个多月后,Marvell也按捺不住,举办了一场 "人工智能时代的加速基础设施 "活动,在活动里着重提到了数据中心的未来预期和增长动力,其中当然也包括了定制芯片。

那么,Marvell对于定制芯片有多少底气呢?

Marvell的AI布局

Marvell的ASIC业务,来自于它在2019年5月花了7.4亿美金从格芯那里收购的Avera,在收购完一年后,Marvell就宣布了提供定制 ASIC SoC 服务,对于客户来说,通过这项服务,不仅能够利用自己现有的IP和定制位,还同时获得了Marvell丰富的IP库,同时大幅缩短研发芯片时间,有百利而无一害

Marvell表示,客户可以使用标准的Marvell芯片,然后添加定制接口、加速器或适合所需工作负载的定制算法,定制工作通常需要 12 到 18 个月的周转时间,一旦定制ASIC芯片完成组合、模拟和验证,Marvell将充当客户与工厂之间的联络人,以确保按时交付。如果客户选择在任何产品中使用与ARM兼容的CPU内核,Marvell还将负责许可和版税交易。

就当时而言,这项服务并没有掀起太大的波澜,即使是博通已经连续为GOOGLE定制数代TPU,获得的营收与利润依旧保持着一个较低的水平,并不足以撬动更大的市场。

不过,最大的云服务厂商——AMAZON,却很乐意为这项服务买单。早在 2020 年12月,AMAZON推出了一款全新的机器学习定制训练芯片 Trainium,与标准的 AWS GPU 实例相比,AWS 承诺可带来 30% 的吞吐量提升、以及降低 45% 的单次引用成本,随后AMAZON又在2023年11月推出了升级版Trainium 2,这两代芯片推出的最大功臣,就是 Marvell的定制部门。

2023年6月,自由时报报道称,Marvell 获得AMAZON AI 订单。通过此次合作,Marvell 将协助AMAZON第二代 AI 芯片(即Trainium 2)的设计,预计2023年下半年启动委托设计,2024年进入量产。

在Marvell官网上,你可以轻松找到它在AWS背后发挥的作用,作为战略供应商,Marvell不仅提供了云优化芯片,帮助满足AWS客户的基础设施需求,还提供了电子光学、网络、安全、存储和定制设计等一系列解决方案。

在Marvell发布的截止至2024年2月3日的第四财季与年度财务报告中,该季度营业收入为14.27亿美金,超出此前预期。Marvell的董事长兼首席实行官马特·墨菲先生强调:“Marvell第四季度营收超过了预期,而人工智能带来的收入增长更是惊人,Marvell的数据中心终端市场的收入环比增幅达到了38%,同比增长则高达54%。”

赶上了人工智能浪潮的Marvell,实质上成为了继英伟达和博通后的第三大芯片赢家。

Marvell的AI业务现状

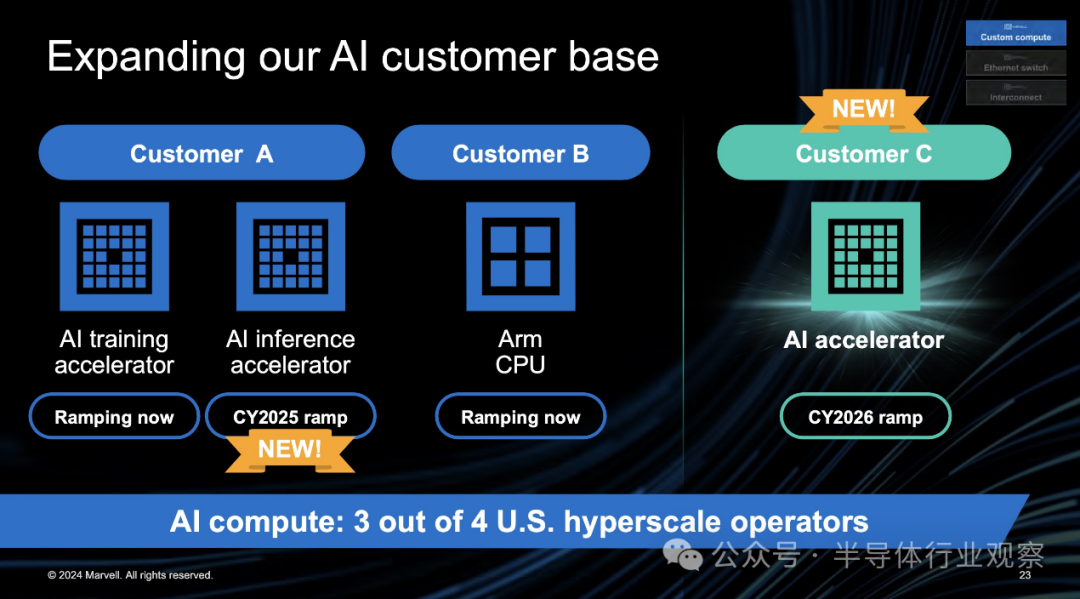

在最新的人工智能活动上,Marvell也是第一时间宣布了关于定制芯片超大规模客户的重要消息,据Needham 分析师 Quinn Bolton称,除了已经为某位客户(可能是AMAZON)推出的人工智能培训加速器之外,Marvell 还计划在 2025 年为另一位客户(可能是GOOGLE)推出人工智能推理加速器。

Marvell提供了一部分关于客户的细节:第一位客户正在将 Marvell 芯片用于其 AI 集群和系统,两家企业正在共同开发新的定制 AI 接口加速器,而Marvell 还在为其第二个超大规模客户设计 Arm计算机处理单元 (CPU),以部署在其云平台和 AI 基础设施中。

首席实行官 Matt Murphy 还宣布了一个重磅消息,Marvell已经获得了第三个 AI 超大规模客户(可能是MicroSoft),两家企业正在合作设计一款 AI 加速器,预计将于 2026 年投入生产,该客户所贡献的收入可能比与前两位客户的总和还要大。他也指出,Marvell 与 AI 超大规模厂商的关系使其“相对于竞争对手(即博通)具有显着优势”。

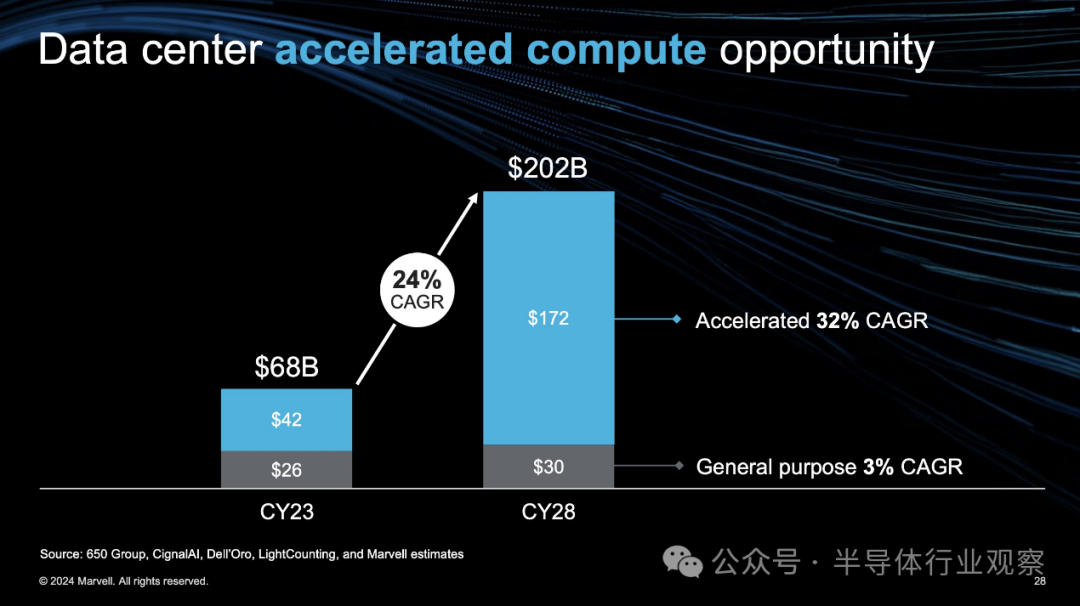

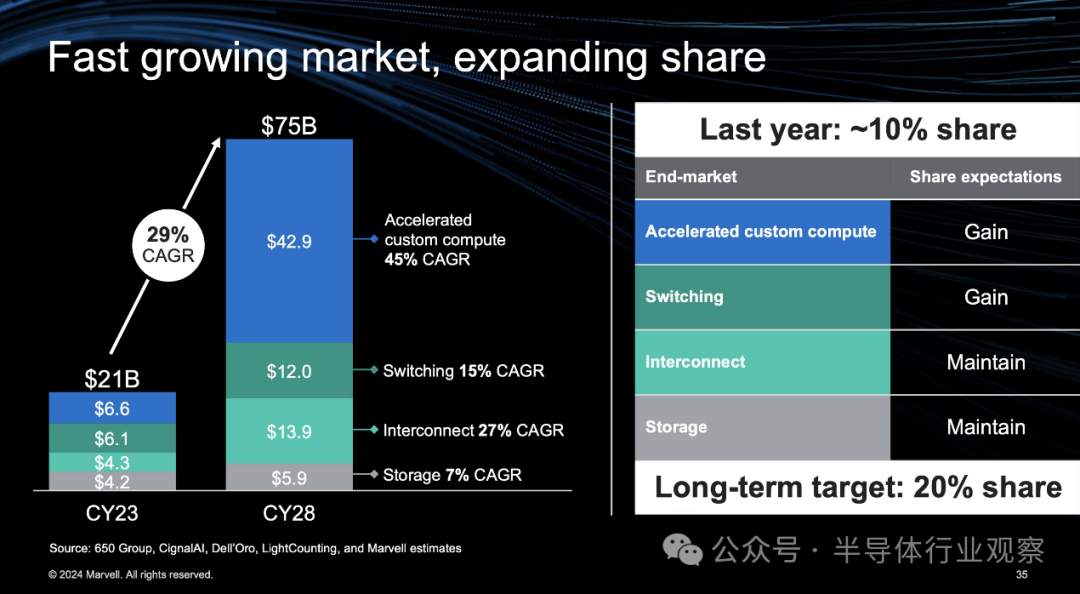

比较有意思的是,Marvell在先容完定制芯片后,还分析了数据中心的市场与机遇。Marvell 认为,传统通用计算将以 3% 的复合年增长率增长,实际上是根据通货膨胀调整后的负增长率,而加速计算市场的复合年增长率将高达 32%,由于超大规模企业构建自己的芯片,定制细分市场将以 45% 的复合年增长率增长,并在 2028 年占据加速计算市场的更大份额。

根据Marvell公布的数据,预计其明年与人工智能相关的总收入将增加两倍,在 2025 财年,人工智能收入将超过 15 亿美金,占总收入的 30%,是前一年人工智能所占份额的三倍,而在与人工智能相关的收入中,交换互联产品约占三分之二,定制计算约占三分之一。

Needham 分析师 Quinn Bolton表示,在互连方面,Marvell通过新市场支撑了超过 40 亿美金的新数据中心。在交换领域,Marvell的路线图很有竞争力,与博通的战斧(Tomahawk)和杰里科(Jericho)路线图相比,Marvell已经获得了更多份额。

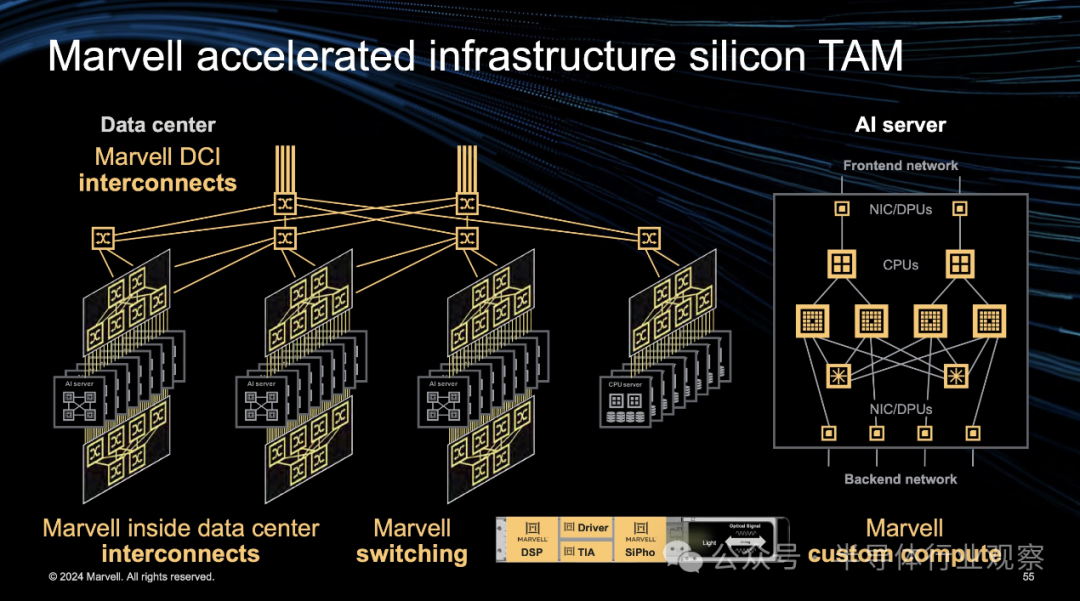

具体而言,Marvell提到数据中心内部的前端网络/后端网络中,其在DSP、驱动器、TIA 方面保持领先,产品率先应用到 8*200G 的 1.6T 光模块中,且积极构建 AEC DSP 产品生态系统,新增 10 亿美金 DSP 潜在市场规模;数据中心之间互联,在相干 DSP、驱动器、TIA、硅光芯片方面保持领先,目前Marvell产品可以覆盖 120km,针对更远距离已经开发出新技术 PCS,使可插拔模块的覆盖范围扩展到 1000 公里,新增 10 亿美金潜在市场规模。

Marvell在交换方面的投资推动了交换和某些互连方面的发展。该企业表示,其数据中心交换研发增加了 2.5 倍,由Innovium 衍生的 Teralynx 10 51.2T 产品已开始量产。

在这一领域中,Marvell 正在与博通正面交锋,其计划加大 AI 云交换方面的投资,目前它已在 12.8T交换机芯片产品杀个实现大规模量产,并推出 51.2T 交换芯片,预计将于 2024 年夏季量产。

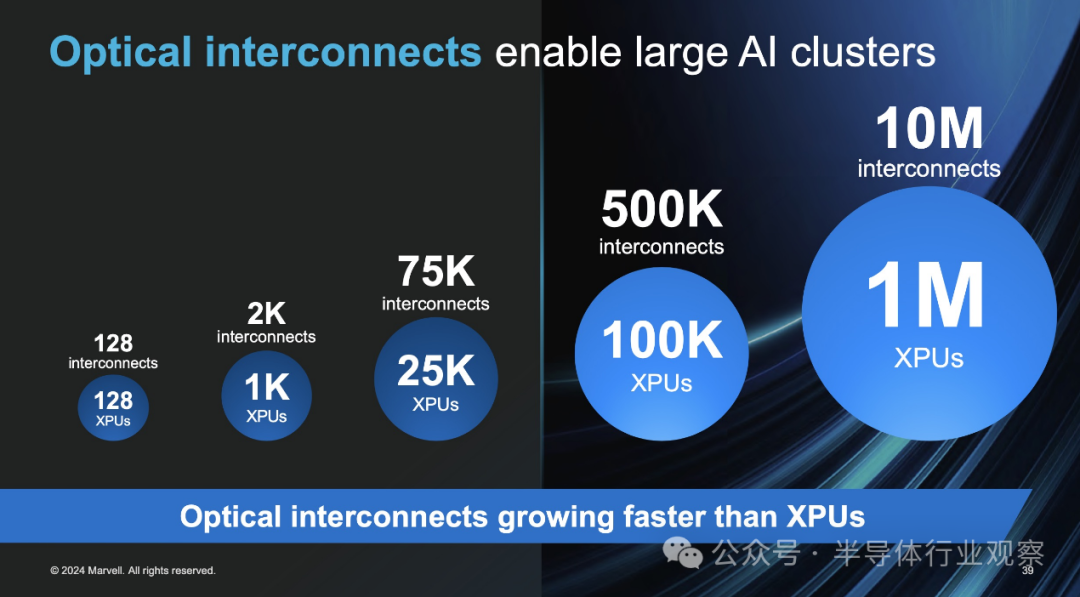

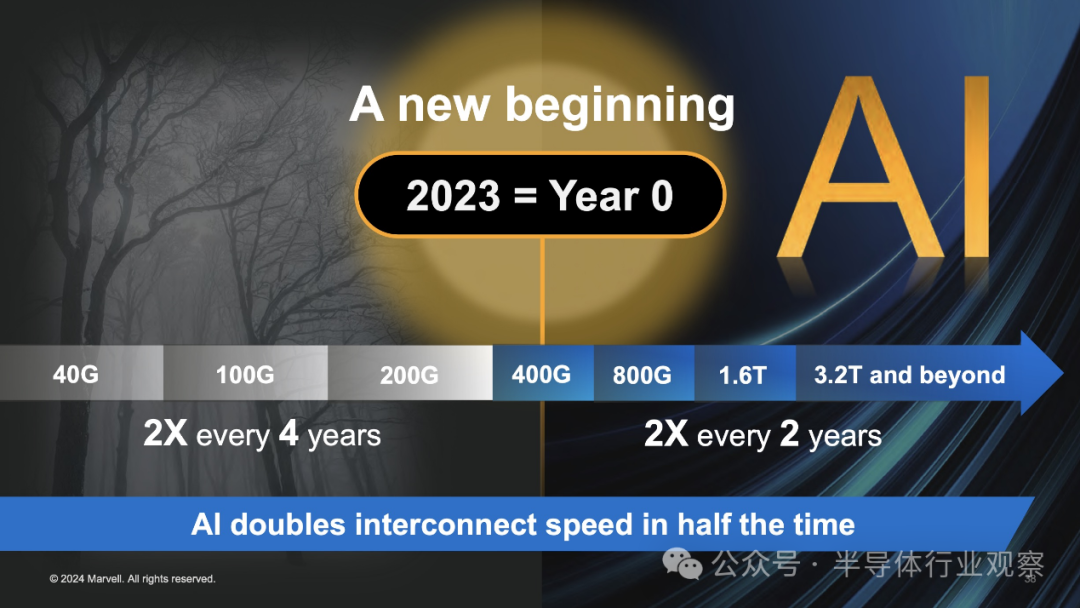

Marvell还详细先容了互连的必要性以及人工智能基础设施中有多少互连,其中包括机箱内互连以及数据中心、前端和后端网络,Marvell表示,随着集群规模的增加,互连需求的增长速度会更快,较大的集群需要更多级别的交换,且目前互连代际转变的速度正在加快, 2023 年作为 AI 元年,AI 在一半的时间内将互联速度提升一倍,互联速度由过去的 4 年两倍变为 2 年两倍,由 400G 向着 1.6T、3.2T 等更高速发展。

此外,Marvell还提到,AI 大规模集群带来更多的光互连需求。ChatGPT 3.0 在 1000XPU 集群上训练,对应 2000 个光学互连(XPU:光模块需求为 1:2);ChatGPT 4.0 在 2.5 万XPU 集群上训练,对应 7.5 万个光学互连(XPU:光模块需求为 1:3),Marvell 预计未来对于更复杂的 AI 大模型,需要 10 万级甚至百万级规模的 XPU 集群。预计 10万级 XPU 集群需要五层交换技术,对应 50 万个光学互连(XPU:光模块需求为1:5);预计 100 万级 XPU 集群需要十层交换技术,对应 1000 万个光学互连(XPU:光模块需求为 1:10)。

Marvell表示,AI 训练和推理对集群存在差异化需求,催化新的基础设施建设。训练时,集群大,数量少。推理时,小集群,但数量多。但这两者都将驱动大量的光互联。同时 AI 发展需要更多的电力、更好的制冷、有望推动更多的数据中心建设、对应更多的地点和更多的互联。AI 集群的连接距离从不到 2 公里增加到 10-20 公里,因此需要具有相干技术的长距离传输特性且与 PAM 连接相似体验的互连技术。

对此,Marvell 不仅拥有交换机,还拥有庞大的光学产品组合以及 DSP 等,在人工智能时代到来之际,Marvell能够藉由自己的互连产品拿下更多市场份额。

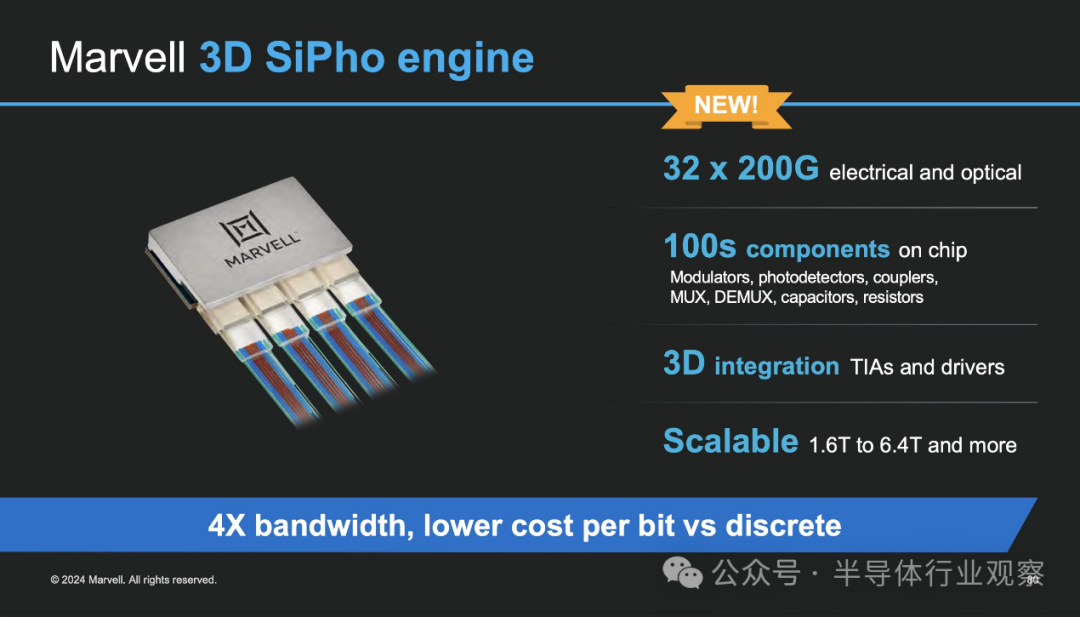

此外的Marvell还宣布了 3D SiPho(硅光子)引擎,该技术将 32 个 200G 链路置于单个芯片上,并能够将其集成到不同的应用中。它讨论了这些 3D SiPho 引擎在许多用例中的使用,包括明年的可插拔模块和未来的光学小芯片。

需要注意的是,虽然博通在之前的活动中提到了51.2T 联合封装光学交换机,但 Marvell 表示其客户尚未为此做好准备,但它已准备好大部分 IP。它还表示,随着速度的提高,因为使用了更低成本的 CW 激光器和更少的组件,SiPho 以更低的成本进行扩展变得更加重要,

另外值得一提的是,Marvell首席实行官Matt Murphy还告诉投资者,就目前而言,定制芯片目前的毛利率低于该企业的现成产品,即所谓的“商业”芯片。

“大家总是说定制业务的毛利率会低于商业型产品。但随着时间的推移,运营利润率实际上会大致持平。” Murphy说。

博通曾在3月表示,其定制芯片利润率将与其企业平均水平持平,这意味着目前Marvell的定制业务还未完全成熟,或是收取的定制费用相较于博通更低一些,随着GOOGLE和MicroSoft这样的超大规模客户加入,Marvell的定制利润率或许会有一定改善。

写在最后

对比博通,Marvell似乎更看重自身产品在AI中发挥的作用,说是情有独钟也不为过。

其中固然有Marvell在市场中处于一个相对弱势的地位的原因,但从另一角度来看,Marvell对于新机遇有着更积极的态度,在2023年之前,Marvell还只有AMAZON一家大客户,而2024年刚开始,Marvell就拥有了四大定制客户中的三家,和行业龙头博通平齐,这样的速度让其他厂商相形见绌。

随着AI基础设施与定制需求的膨胀,博通和更积极拥抱AI的Marvell的差距会不会进一步缩小呢?大家拭目以待。

|  259

259 259

259