P4君 云深知网络

互联网开卷顶会论文

阿里高性能网络入选 SIGCOMM 阿里大语言模型训练网络 HPN 揭开面纱

本篇可以看作是

官方出品的阿里 HPN 中文版

摘要

拥有千亿级别参数的大语言模型(large language model,LLM)已为今天的人工智能和云服务带来了巨大的技术和商业变革。然而,大模型训练与传统的通用云计算(例如,AMAZONEC2弹性计算服务)之间存在较多根本性的网络行为差异,从而带来了很多新的挑战,主要包括流量模式差异造成负载难均衡(挑战1)、多训练任务通信竞争影响GPU利用率(挑战2),以及对网络故障的高敏感性(挑战3)等。因此,为通用云计算设计的数据中心网络技术(例如,网络架构、选路方法、流量调度,以及可靠性保障方法等)已不适合今天的大模型训练,这要求专门为大模型训练设计新型的数据中心网络以及配套的技术方案。

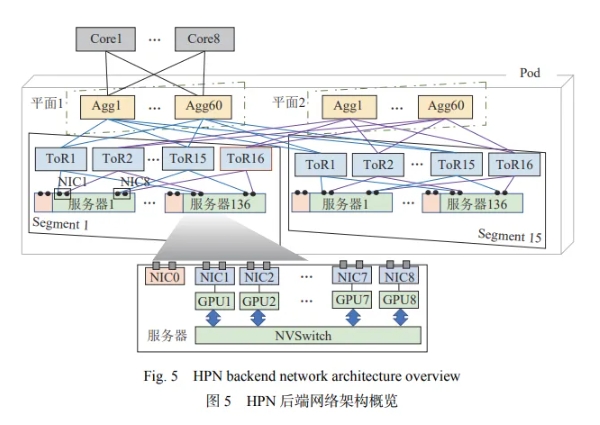

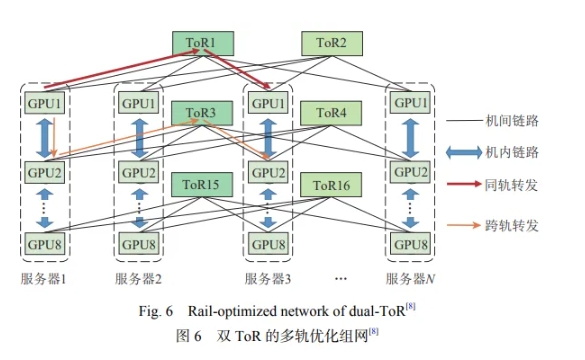

本文先容了阿里云专门为大模型训练设计的数据中心网络HPN以及多任务通信调度方法Crux解决上述3个挑战。HPN通过引入了一种2层、双平面(dual-plane)的网络架构,不但能够在一个Pod内高速互联15000个GPU,还能做到适用大模型训练的精准选路(解决挑战1)。此外,HPN提出了一种新型的去堆叠双ToR(top-of-rack)设计来替代传统数据中心网络的单ToR交换机连接方式,根本性地避免了单点失效可靠性风险(部分解决挑战3)。针对挑战2,Crux通过对GPU利用率优化问题的建模与证明,将该NP完全问题近似成GPU强度相关的流量调度问题。随后,Crux提出了一个方法优先处理具有高GPU计算强度的任务流,从而极大降低了多任务的通信竞争,优化了GPU利用率。与相关工作对比,Crux可以将GPU利用率提高多达23个百分点。

HPN和Crux均已在阿里云生产环境规模化部署超过8个月,后续会持续演进迭代. 在此基础上,进一步展望了大模型训练与推理领域可能的研究方向,为后续工作提供引导性建议。

每台服务器配置了9个网卡,每个网卡提供2×200 Gbps的带宽。其中,一个网卡连接至前端网络,其余8个网卡则连接至后端网络,负责训练期间的数据传输。这8个网卡中的每一个都直接连接至对应的GPU,形成所谓的“轨”(rail),确保每个GPU拥有专用的400 Gbps RDMA网络吞吐能力,总体带宽高达3.2 Tbps。

如果服务器1中的GPU1想要与服务器3中的GPU2通信,转发路径是服务器1中的GPU1→服务器1中的GPU2→ToR3→服务器3中的GPU2。HPN允许3.2 Tbps(8×400 Gbps)流量通过多达16个ToR交换机送达单个服务器。与经典Clos相比,HPN中的一个Segment可包含的GPU数量增加了8倍. 每组双ToR交换机可服务128个GPU,16个ToR交换机共同连接1024个GPU,减少了转发延迟,并提供了最高的性能. 更重要的是,该设计显著减少了跨越汇聚层的流量,尽可能做到GPU直连。

首先,双ToR设计允许单个网卡的2×200 Gbps带宽通过2个ToR交换机提供服务,这一设计直接使得网络规模加倍。结合最新的51.2 Tbps单芯片交换机和多轨优化网络,单个Segment能够容纳1000个GPU。汇聚层的双平面设计进一步释放了每个汇聚交换机中一半数量的端口,极大地提升了网络的扩展性。最后,通过汇聚-核心的15∶1带宽收敛比,HPN实现了在一个Pod中支撑15000个GPU的设计目标。目前根据实际观察,不会有单任务超过万卡GPU需求,因此一个Pod已经能够覆盖大家当前最大的训练任务。通过单个Pod支撑15000个GPU,大家进一步减少了连接多个Pod所需的不必要交换机数量。根据阿里云内部统计,HPN的设计节省了大约30%的总体网络建设成本。

面向大模型时代的网络基础设施研究:挑战、阶段成果与展望.pdf

(1.57 MB, 下载次数: 5)

面向大模型时代的网络基础设施研究:挑战、阶段成果与展望.pdf

(1.57 MB, 下载次数: 5)

|  181

181 181

181